Executive Summary - Yapay Zekâ - 2

Profesyoneller için yapay zekâ, teknoloji ve pazarlama gündemi

Executive Summary, akıp giden gündemi yakalayamayacağını peşinen kabul eden bir haftalık özet. İki yüze yakın yayından, binlerce makale arasından seçtiğim ve okuduğum teknoloji, yapay zekâ ve pazarlama içeriklerinden damıttığım birkaç başlık ve bu başlıklar üzerine görüş ve fikirlerim. İlk sayısı geçen hafta çıktı. Buradan okuyabilirsiniz.

Yenisi ise hemen aşağıda. 😀

Keyifli okumalar.

Bu sayıda neler var?

Bu hafta üç konu başlığı ile karşınızdayım. İlk başlıkta, OpenAI ve güvenlik meseleleri ile ilgili. Lansman sonrası gelen istifalar, güvenlik ile ilgili eski çalışanların açıklamaları ve tüm bunlara ek olarak işten ayrılanların tehdit edildiği ile ilgili iddiaları konuşacağız.

İkinci başlıkta yapay zekâ teknolojisini var eden altyapıyı ve bu altyapının dünya kaynaklarını nasıl tükettiğinden bahsedeceğiz.

Son konumuz ise yapay zekânın kullanımı ve erişimi ile ilgili gözden kaçanları değerlendireceğimiz bir içerik olacak.

Hadi başlıyoruz!

1. Dışı “Open”, İçi Kapalı

Kasım 2023’de, OpenAI yönetim kurulu ansızın Sam Altman’ın görevine son verdiğini açıkladı ve tabir yerinde ise ortalık karıştı. OpenAI duyurusunda çok detay vermeyerek “güvenilirlik” vurgusu yapıyordu.

"Sayın Altman'ın ayrılışı, yönetim kurulu tarafından yapılan ve kendisinin yönetim kurulu ile iletişiminde sürekli olarak samimi olmadığı ve yönetim kurulunun sorumluluklarını yerine getirmesini engellediği sonucuna varılan tatışmalı bir inceleme sürecinin ardından gerçekleşmiştir. Yönetim kurulu artık onun OpenAI'yi yönetmeye devam edebileceğine güvenmemektedir."

Geçen haftalarda eski yönetim kurulu üyesi Helen Toner, Sam Altman’ın kovulması hakkında açıklamalarda bulundu. Öne çıkan başlıkları kısaca derliyorum ve hepimizi korkutması gereken kısımları koyu işaretliyorum.

Toner, yönetim kurulunun Altman'a güvenmeyi bırakmasının nedenlerinden birinin OpenAI Startup Fund'ın sahibi olduğunu yönetim kuruluna söylememesi olduğunu; bir diğerinin ise şirketin güvenlik süreçleri hakkında "birçok kez" yanlış bilgi vermesi olduğunu söylüyor.

İki yöneticinin doğrudan yönetim kuruluna Altman'la yaşadıkları deneyimlerden bahsetmesi, OpenAI'deki zehirli atmosferi anlatması, onu "psikolojik tacizle" suçlaması ve Altman'ın "farklı durumlarda yalan söylediğine ve manipülatif davrandığına" dair kanıtlar sunmasının ardından yönetim kurulu nihayet harekete geçti.

"ChatGPT Kasım 2022'de piyasaya çıktığında yönetim kurulu önceden bilgilendirilmedi. ChatGPT'yi Twitter'dan öğrendik," diyor Toner.

Yukarıdaki açıklamadan beni korkutan kısımlar zehirli çalışma atmosferi, güvenlik süreçleri ile yalan söylenmesi, ChatGPT lansmanını Twitter’dan öğrenen yönetim kurulunun görünen o ki herhangi bir yetkisinin ve etkisinin olmaması.

ChatGPT’nin yeni özelliklerinin tanıtıldığı lansman'dan hemen sonra gelen istifalar OpenAI’ın güvenlik yaklaşımının sorgulanmasına sebep oldu. Yönetim kurulunda bulunan ve Sam Altman’ın önce görevden alınmasını isteyen sonra da geri dönüşünü destekleyen Ilya Sutskever klişe bir mesaj ile görevinden ayrıldığını duyurdu. Etliye, sütlüye bulaşmadı. Ama Jan Leike için aynısını söyleyemeyeceğim. Kısa bir istifa tweeti altında “güvenlik kültüründen ve süreçlerinden” uzaklaşıldığını belirterek açık açık çekincelerini belirtti.

Bu istifalar, bambaşka bir tartışmayı ateşledi. Kimse istifa mı ettiklerini, görevden mi alındıklarını net bir şekilde bilmiyordu. Sadece Ilya ve Jan için değil, tüm eski OpenAI çalışanları sessizlik yemini etmiş gibiydiler.

Kısa süre sonra sebebinin, tüm çalışanların tabi olduğu ifşa etmeme ve kötülememe hükümlerini içeren son derece kısıtlayıcı işe alım sözleşmesi olduğu açığa çıktı. Öyle bir sözleşme düşünün ki hayatlarının geri kalanı boyunca eski işverenlerini eleştirmeleri yasak. Gizlilik Sözleşmesi'nin var olduğunu kabul etmek bile suç. Yaptırım ise şirkette çalıştığı süre içerisinde çalışarak elde ettiği milyonlarca dolar değerindeki tüm hisse haklarından vazgeçmek. OpenAI'den "AGI zamanında sorumlu davranacağına dair güvenini kaybettiği için" ayrıldığını açıklayan eski bir çalışan, Daniel Kokotajlo, belgeyi imzalamadan ayrılmak için muhtemelen büyük bir meblağa dönüşecek olan paradan vazgeçmek zorunda kaldığını kamuoyuna doğruladı. Söylentileri doğrulayan sözleşme geçen haftalarda medyaya sızdı.

Bu sızma sonrası OpenAI aşağıda göreceğiniz politik bir basın açıklaması ile konuyu geçiştirmeye çalıştı. Yeterli olmamış olacak ki Sam Altman konu hakkında ek bir tweet attı.

"Mevcut ya da eski hiçbir çalışanımızın kazanılmış sermayesini iptal etmedik ve insanlar ayrıldıklarında bir ibra ya da kötülememe anlaşması imzalamazlarsa da etmeyeceğiz."

Tüm bunların üzerine 4 Haziran’da, bir grup mevcut ve eski OpenAI ve Google DeepMind çalışanı, AI şirketlerinin pazar hakimiyeti için AGI geliştirme yarışında “pervasız” bir gizli kültür benimsediğini iddia eden bir açıklamayı kaleme aldılar. Yazıda, AI sistemlerinin yanlış yönetildiğinde ciddi zararlar verebileceği ve şirketlerin bu riskleri öncelikli olarak finansal kazanç için göz ardı ettikleri belirtiliyor.

Çalışanlar, şirketlerin eleştirilerini önlemek için gizlilik anlaşmaları kullandığını ve bu durumun güvenlik endişelerini dile getirmeyi zorlaştırdığını belirtti. Grup, çalışanların anonim olarak endişelerini bildirebileceği bir süreç ve misilleme yapılmamasını talep ediyor.

Çalışanlar, gelişmiş yapay zekâ şirketlerinden dört açık talepte bulunuyor.

Çalışanları "riskle ilgili endişeler" nedeniyle işverenlerini eleştirmelerini engelleyen anlaşmalara zorlamayı durdurmak.

Çalışanların endişelerini yönetim kurulu üyelerine ve diğer ilgili düzenleyicilere veya kuruluşlara iletmeleri için anonim bir süreç oluşturmak.

"Açık eleştiri kültürünü" desteklemek.

"Süreçler başarısız olduktan sonra riskle ilgili gizli bilgileri" paylaşan eski ve mevcut çalışanlara karşı misilleme yapmamak.

Şu an ki üretken yapay zekâ uygulamalarını bile devrim olarak nitelendiriyoruz. Bir sonraki adım (muhtemelen AGI) çok daha büyük bir devrim yaratacak. Sektördeki tüm rekabet bu büyük adımı atmak üzerine kurulu. Bu adımı atmak için şirketler tüm kaynaklarını seferber etmiş durumdalar.

Silikon Vadisi için güvenliği ayak bağı gibi görmek, kuralları çiğnemek, üstünlüğünü (gücünü) kullanarak rekabet avantajı yaratmak OpenAI’a ya da yapay zekâ geliştiren şirketlere özgü değil. Dolayısıyla tüm tartışmaların ortasında OpenAI’ı görüyoruz ancak diğer şirketlerde de durum pek de farklı değil. Bu defa riskleri görmezden gelmenin, güvenlik konusunu ciddiye almamanın bedeli daha ağır olabilir.

Bölümün sonunda size son bir tavsiyem daha var. Güvenlik ile ilgili daha kötü haberlere de hazırlıklı olun. OpenAI, Google Deep Mind gibi şirketler ne olursa olsun göz önündeler ve üzerlerinde güçlü bir kamuoyu baskısı var. Ama adını bile duymadığımız, Amerika eksenli teknoloji ekosisteminin dışında yapay zekâ geliştiren ülkeleri unutmayın. Geçen hafta en çok konuşulan işlerden birisi OpenAI Sora’nın rakibi Çinli bir firmanın teknolojisi KLING idi. Örnek videoları ile kendilerini duyurana kadar kimse bu şirketten haberdar bile değildi. Çin’de AI üzerine geliştirilen teknolojilerin bir çoğundan haberdar değiliz. Risklerinden de, güvenlik yaklaşımlarından da.

2. Güç Savaşları

Teknolojik ilerlemenin son kullanıcı açısından elle tutulur yanı cep telefonu, bilgisayar, streaming servisleri gibi deneyim tabanlı gelişmeler gibi gözükse de bu işin bir de tüketicinin çok da farkında olmadığı altyapı ve sunucu tarafı var. Milyonlarca uygulamanın, milyarlarca kullanıcıya ait türlü türlü veriyi biriktirdiği, işlediği devasa sunuculardan bahsediyorum. Amazon Web Services, Microsoft Azure, Google Cloud vb. en bilinenleri. Üzerinde saklanan verilerin yanında tüm bunlara erişmemizi sağlayan, çalıştıran bir işlemci gücü. Bugün tüm bu güce bir de yapay zekâ uygulamalarını ekleyin. İhtiyacımız olan işlemci gücü, sunucu miktarı, enerji katlanarak arttı, daha da artacak.

Bu devasa altyapının var olmak ve büyümek için ihtiyacı olan mineraller, işlemesi için gerekli elektrik enerjisi ve açığa çıkan ısıyı düşürmek için kullanılan su bu bölümün konusu. “Spoiler alert: Durum feci”

Dünya çapındaki bulut veri merkezlerinin sayısına ilişkin tahminler yaklaşık 9.000 ila yaklaşık 11.000 arasında değişmekte. Daha fazlası da yapım aşamasında. Uluslararası Enerji Ajansı (IEA), veri merkezlerinin 2026 yılındaki elektrik tüketiminin 2022 yılının iki katı olacağını öngörmektedir: 1.000 terawatt, yani kabaca Almanya'nın şu anki toplam tüketiminin iki katına eşit. Daha da kötüsü bu hesaplama da yapay zekâ işlemcileri için duyulan ihtiyaç yok. Yapay zekâ olmayan bir dünyanın işlemci ihtiyacı hesaplanmış.

UC Riverside'da akademisyen Shaolei Ren, Microsoft'un soğutma sistemleri için yıllık su kullanımı hesaplamalarından yola çıkarak, GPT-3 ile bir soru-cevap seansına katılan bir kişinin (yaklaşık 10 ila 50 yanıt) yarım litre tatlı su tükettiğini tahmin ediyor.

Ren, 2022 yılında Google'ın veri merkezlerinin soğutma için yaklaşık 20 milyar litre tatlı su tükettiğini söylüyor. Yakın zamanda yapılan bir araştırmaya göre, Google'ın veri merkezleri 2022 yılında 2021 yılına kıyasla yüzde 20 daha fazla su kullanırken, Microsoft'un su kullanımı aynı dönemde yüzde 34 arttı. Microsoft’un veri merkezlerinde ChatGPT-3’ü eğitmek için yaklaşık 700.000 litre su kullanıldığı tahmin edilmekte.

2021 yılında, makine öğrenmesi servisleri Google veri merkezlerinin enerji harcamasının %15’ini oluşturuyordu. Ortada yapay zekânın esamesi okunmuyordu daha. Aynı çalışmaya göre makine öğrenmesi servislerini sunucuda değil (bugün Apple WWDC 2024’te duyurulduğu gibi cep telefonunda çalıştırırsak) 100 kat daha fazla karbondioksit salınımı yapacağız.

OpenAI tarafından San Francisco, Kaliforniya'da oluşturulan sohbet robotu ChatGPT'nin halihazırda 33.000 evin enerjisini tükettiğini göstermekte. Yine üretken yapay zekâ tarafından yönlendirilen bir aramanın, geleneksel bir web aramasının dört ila beş katı enerji kullandığı tahmin edilmekte.

İşin bir de madencilik kaynaklı problemleri var. Yapay zekâ sistemlerinin enerji ihtiyaçlarını karşılamak için Amerika’da kömür santrallerinin faaliyet süreleri uzatılıyor. Ayrıca, lityum ve kobalt gibi mineraller en yaygın olarak otomotiv sektöründeki bataryalarla ilişkilendirilse de veri merkezlerinde kullanılan bataryalar için de olmaz ise olmaz mineraller. Bu minerallerin çıkartılması önemli miktarda su tükettiği gibi çevre kirliliği yaratmakta. Üstelik bu madenlerin çıkarılması da genellikle insan hakları ihlalleri ve kötü çalışma standartlarıyla da ilişkili.

Yapay zekânın getirdiklerin yanında götürdükleri kısmı pek de farkında olmadığımız bir çevre felaketi. Hızla yaygınlaşan yapay zekânın tüm dünya için sürdürülebilirlik hedefleri açısından risk olduğu aşikâr.

Bonus enerji bölümü bilgisi:

2018 yılında, viral şarkı Despacito'nun YouTube'da 5 milyar kez tıklanması, ABD'de 40.000 evin yıllık ısıtılması için gereken enerji miktarını kullanmıştır.

Ek okuma için: https://spectrum.ieee.org/cloud-computings-coming-energy-crisis

3. Yapay zekânın Bilinirlik problemi

Yönetici özetimizin son konusu yapay zekânın bilinirliği. Gündemimizden düşmeyen, devrim devrim diye yazıp çizdiğimiz yapay zekâ teknolojileri vatandaşta pek de karşılık bulmamış gibi gözüküyor.

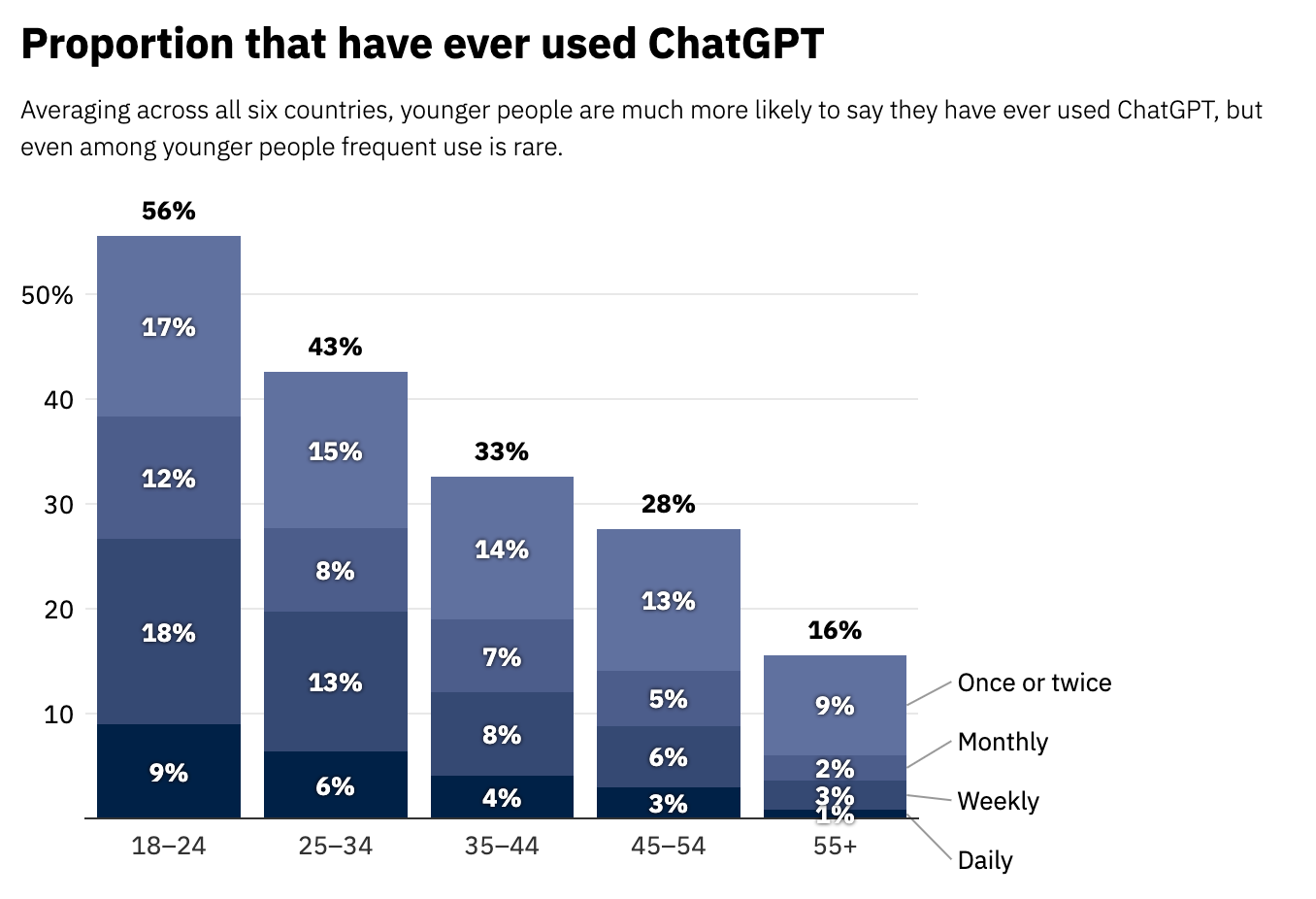

Oxford Üniversitesi ve Reuters Enstitüsü tarafından yürütülen ve altı ülkede (Arjantin, Danimarka, Fransa, Japonya, Amerika Birleşik Devletleri ve Birleşik Krallık) yaklaşık 12.000 kişiye yapay zekâ hakkında sorular sorulan yeni bir çalışmada, katılımcıların büyük bir kısmı OpenAI'nin ChatGPT'si veya Microsoft Copilot gibi popüler araçları hiç kullanmadıklarını ve yüzde 20 ila 30'u bu araçları hiç duymadıklarını söyledi.

Yaş ve kullanım sıklığı grafiğine baktığımızda beklediğimiz gibi gençlerin kullanımı daha fazla gözükse de sıklığı onlarda bile oldukça az. ChatGPT düşündüğümüz kadar geniş kitlelere henüz ulaşmıyor olabilir. Acaba biz (profesyoneller) yapay zekâyı abartma eğiliminde miyiz? Çalışmaya göre, vatandaşın ilgisi ile yapay zekâ üzerine yazıp çizilenler arasında bir uyumsuzluk olduğu aşikâr.

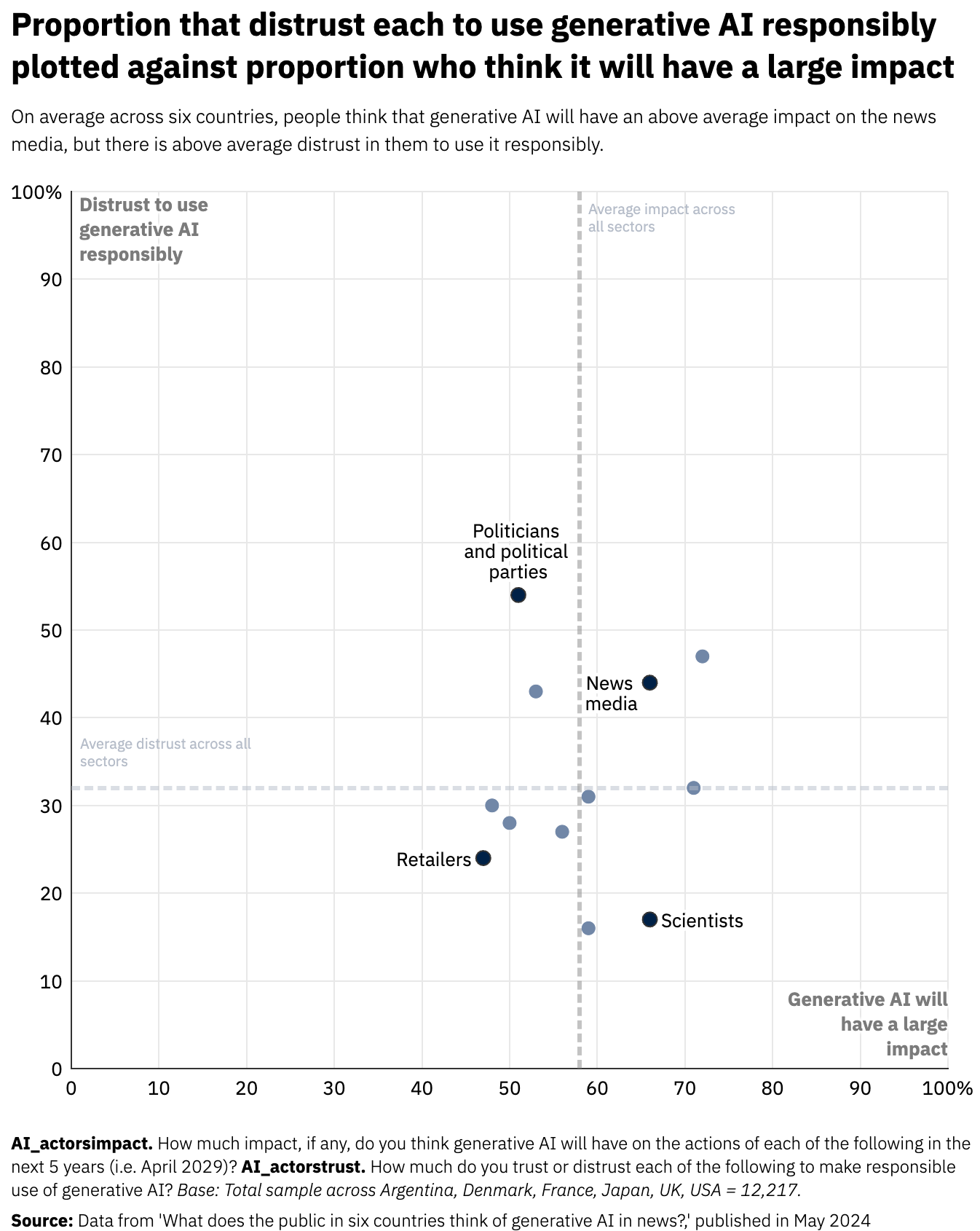

Çalışmanın tamamını incelemenizi şiddetle öneririm. Çok ilginç veriler var. Benim ilginç bulduğum bir grafiği aşağıda paylaşıyorum. Üretken yapay zekânın sorumlu bir şekilde kullanılacağına güvenmeyenlerin oranı ile büyük bir etkisi olacağını düşünenlerin oranını tek bir grafikte toplamışlar.

Grafikte dört farklı alan var. Ayrı ayrı açıklamama izin verin.

İlk alan: İnsanların üretken yapay zekânın nispeten büyük bir etkiye sahip olmasını beklediği ancak nispeten daha azının sorumsuzca kullanılacağını düşündüğü sektörler (sağlık ve bilim).

İkinci alan: İnsanların etkinin o kadar büyük olmayabileceğini düşündüğü ve nispeten daha azının sorumsuzca kullanılmasından korktuğu sektörler (sıradan insanlar ve perakendeciler).

Üçüncü alan: Nispeten az sayıda insanın büyük bir etki beklediği ve nispeten daha fazla insanın sorumsuz kullanımdan endişe ettiği sektörler (hükümet ve siyasi partiler).

Dördüncü alan: Daha fazla insanın büyük etki beklediği ve daha fazla insanın ilgili aktörler tarafından sorumsuzca kullanılmasından korktuğu sektörler (sosyal medya ve haber medyası).

Tüm bu başlıktaki verilerden ne anlamalıyım derseniz, özetin özeti:

Üretken yapay zekâ henüz kitlelere ulaşmış değil. Dar bir kitle (yoğun olarak daha genç nesiller), düşük frekanslarla kullanıyorlar. Henüz büyük çapta etki yaratabilmiş, ya da kabullenilmiş değil. Günlük hayata etkisi henüz sınırlı. Ama hızla gelecek ve tüm hayatımızı değiştirecek. Özellikle medya, haberler ve siyasetçiler bu teknolojileri kötü kullanmaya meyilliler.

Ben bu özeti hazırlarken Apple WWDC 2024 lansmanı yapıldı. Ona özel bir bülten çıkarmayı düşünüyordum. O kadar kötü ve boş bir lansmandı ki tüm yazma heyecanımı yitirdim. Ama yine de hemen öncesi attığım tweet’e bakabilirsiniz. Gelecek haftanın “Executive Summary”sinde kısa da olsa değinirim. (Değinmedi.🤣)

Gündeme seyirci kalmamak için haftaya yeni başlıklar, yeni yorumlar ile karşınızda olacağım.

İyi haftalar!